Xem danh mục

Web Crawler là gì? Lập chỉ mục tìm kiếm là gì?

- Web Crawle, hay còn gọi là web spider, là một loại bot thường được vận hành bởi các công cụ tìm kiếm như Google và Bing. Mục đích của họ là lập chỉ mục nội dung của tất cả các trang web trên Internet để những trang web đó có thể xuất hiện trong kết quả của công cụ tìm kiếm. cùng chuyennghiep.vn tìm hiểu nào.

>> Xem thêm: Khóa học thiết kế website

Web Crawler là gì?

- Web Crawler dịch sang tiếng Việt là Trình thu thập thông tin web, là quá trình lập chỉ mục dữ liệu trên các trang web bằng cách sử dụng một chương trình hoặc tập lệnh tự động. Các tập lệnh hoặc chương trình tự động này được biết đến với nhiều tên gọi, bao gồm trình thu thập thông tin web, trình thu thập thông tin, trình thu thập dữ liệu mạng nhện và thường được rút ngắn thành trình thu thập thông tin.

- Trình thu thập dữ liệu web sao chép các trang để công cụ tìm kiếm xử lý, công cụ này sẽ lập chỉ mục các trang đã tải xuống để người dùng có thể tìm kiếm hiệu quả hơn. Mục tiêu của trình thu thập thông tin là tìm hiểu nội dung của các trang web. Điều này cho phép người dùng truy xuất bất kỳ thông tin nào trên một hoặc nhiều trang khi cần.

Lập chỉ mục tìm kiếm là gì?

- Lập chỉ mục tìm kiếm giống như tạo một danh mục thẻ thư viện cho Internet để công cụ tìm kiếm biết vị trí trên Internet để truy xuất thông tin khi một người tìm kiếm nó. Nó cũng có thể được so sánh với mục lục ở phía sau của một cuốn sách, trong đó liệt kê tất cả các vị trí trong cuốn sách mà một chủ đề hoặc cụm từ nhất định được đề cập đến.

- Lập chỉ mục chủ yếu tập trung vào văn bản xuất hiện trên trang và siêu dữ liệu * về trang mà người dùng không nhìn thấy. Khi hầu hết các công cụ tìm kiếm lập chỉ mục một trang, chúng sẽ thêm tất cả các từ trên trang vào chỉ mục - ngoại trừ các từ như "a," "an" và "the" trong trường hợp của Google. Khi người dùng tìm kiếm những từ đó, công cụ tìm kiếm sẽ duyệt qua chỉ mục của tất cả các trang nơi những từ đó xuất hiện và chọn những từ phù hợp nhất.

- Trong ngữ cảnh lập chỉ mục tìm kiếm, siêu dữ liệu là dữ liệu cho các công cụ tìm kiếm biết nội dung của trang web. Thường thì tiêu đề meta và mô tả meta là những gì sẽ xuất hiện trên các trang kết quả của công cụ tìm kiếm, trái ngược với nội dung từ trang web hiển thị cho người dùng.

>> Xem thêm khóa học đào tạo seo tại đây: https://chuyennghiep.vn/dao-tao-seo

Trình thu thập dữ liệu web hoạt động như thế nào?

- Internet không ngừng thay đổi và mở rộng. Vì không thể biết có bao nhiêu tổng số trang web trên Internet, các chương trình thu thập thông tin web bắt đầu từ một hạt giống hoặc một danh sách các URL đã biết. Trước tiên, họ thu thập dữ liệu các trang web tại các URL đó. Khi họ thu thập dữ liệu các trang web đó, họ sẽ tìm thấy các siêu liên kết đến các URL khác và họ thêm các liên kết đó vào danh sách các trang để thu thập thông tin tiếp theo.

- Với số lượng lớn các trang web trên Internet có thể được lập chỉ mục để tìm kiếm, quá trình này có thể diễn ra gần như vô thời hạn. Tuy nhiên, trình thu thập thông tin web sẽ tuân theo một số chính sách nhất định giúp nó chọn lọc hơn về những trang nào cần thu thập thông tin, trình tự thu thập thông tin chúng và tần suất thu thập thông tin chúng lần nữa để kiểm tra các bản cập nhật nội dung.

>> Xem thêm: DMCA là gì? Những điều quan trọng về DMCA mà bạn cẩn phải biết

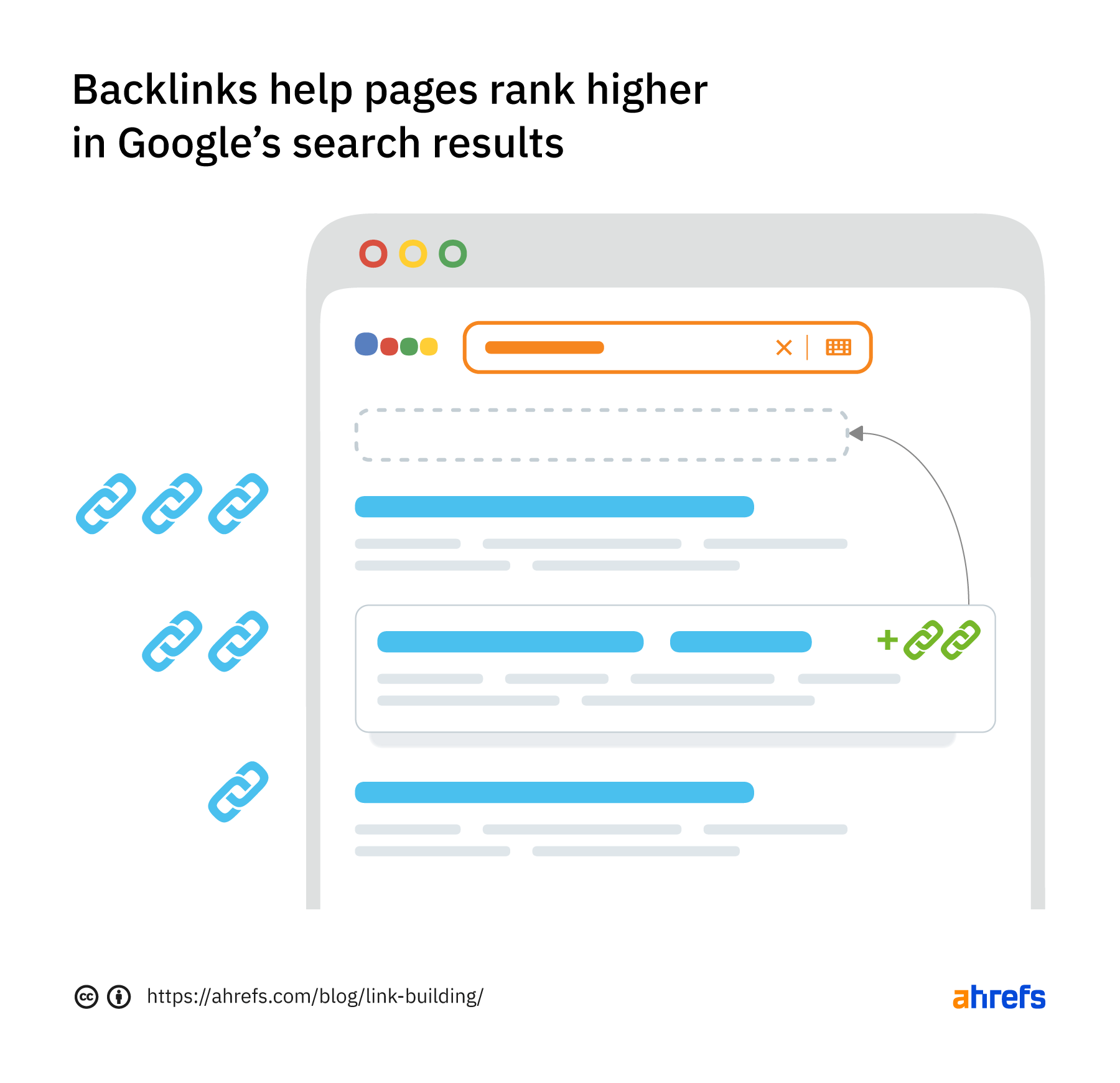

Tầm quan trọng tương đối của mỗi trang web

- Hầu hết các trình thu thập dữ liệu web không thu thập thông tin toàn bộ Internet có sẵn công khai và không nhằm mục đích; thay vào đó, họ quyết định trang nào sẽ thu thập dữ liệu đầu tiên dựa trên số lượng các trang khác liên kết đến trang đó, lượng khách truy cập mà trang đó nhận được và các yếu tố khác biểu thị khả năng chứa thông tin quan trọng của trang.

- Ý tưởng là một trang web được nhiều trang khác trích dẫn và có nhiều khách truy cập có khả năng chứa thông tin chất lượng cao, có thẩm quyền, vì vậy, điều đặc biệt quan trọng là công cụ tìm kiếm phải lập chỉ mục nó - giống như thư viện có thể làm đảm bảo giữ nhiều bản sao của một cuốn sách được nhiều người xem.

Xem lại các trang web

- Nội dung trên Web liên tục được cập nhật, xóa hoặc di chuyển đến các vị trí mới. Trình thu thập thông tin web sẽ cần phải truy cập lại các trang theo định kỳ để đảm bảo rằng phiên bản mới nhất của nội dung được lập chỉ mục.

Yêu cầu về robots.txt

- Trình thu thập dữ liệu web cũng quyết định những trang nào sẽ thu thập thông tin dựa trên giao thức robots.txt (còn được gọi là giao thức loại trừ rô bốt). Trước khi thu thập thông tin một trang web, họ sẽ kiểm tra tệp robots.txt được lưu trữ bởi máy chủ web của trang đó.

- Tệp robots.txt là một tệp văn bản chỉ định các quy tắc cho bất kỳ bot nào truy cập vào trang web hoặc ứng dụng được lưu trữ. Các quy tắc này xác định những trang nào mà bot có thể thu thập thông tin và chúng có thể theo dõi những liên kết nào. Ví dụ: hãy xem tệp robots.txt của Cloudflare.com .

- Tất cả các yếu tố này có trọng số khác nhau trong các thuật toán độc quyền mà mỗi công cụ tìm kiếm xây dựng vào các chương trình nhện của họ. Trình thu thập dữ liệu web từ các công cụ tìm kiếm khác nhau sẽ hoạt động hơi khác nhau, mặc dù mục tiêu cuối cùng là giống nhau: tải xuống và lập chỉ mục nội dung từ các trang web.

>> Xem thêm: Mobile-First Indexing là gì? 9 điều bạn cần biết về Mobile-First Indexing

Tại sao trình thu thập thông tin web được gọi là 'trình thu thập thông tin'?

- Internet, hoặc ít nhất là phần mà hầu hết người dùng truy cập, còn được gọi là World Wide Web - trên thực tế, đó là nơi xuất phát phần "www" của hầu hết các URL trang web. Việc gọi các bot của công cụ tìm kiếm là "nhện" là điều hoàn toàn tự nhiên, bởi vì chúng thu thập dữ liệu trên khắp các trang Web, giống như những con nhện thực sự thu thập dữ liệu trên mạng nhện.

Có nên luôn cho phép các bot trình thu thập thông tin web truy cập các thuộc tính web không?

- Điều đó phụ thuộc vào thuộc tính web và nó phụ thuộc vào một số yếu tố. Trình thu thập dữ liệu web yêu cầu tài nguyên máy chủ để lập chỉ mục nội dung - chúng đưa ra các yêu cầu mà máy chủ cần phản hồi, giống như người dùng truy cập trang web hoặc các bot khác truy cập trang web. Tùy thuộc vào số lượng nội dung trên mỗi trang hoặc số lượng trang trên trang web, lợi ích tốt nhất của nhà điều hành trang web có thể là không cho phép lập chỉ mục tìm kiếm quá thường xuyên, vì lập chỉ mục quá nhiều có thể làm hỏng máy chủ, tăng chi phí băng thông hoặc cả hai.

- Ngoài ra, các nhà phát triển hoặc công ty có thể không muốn một số trang web có thể khám phá được trừ khi người dùng đã được cung cấp một liên kết đến trang (mà không đặt trang sau tường phí hoặc đăng nhập).

- Một ví dụ về trường hợp như vậy đối với các doanh nghiệp là khi họ tạo một trang đích dành riêng cho một chiến dịch tiếp thị, nhưng họ không muốn bất kỳ ai không được chiến dịch nhắm mục tiêu truy cập vào trang. Bằng cách này, họ có thể điều chỉnh thông điệp hoặc đo lường chính xác hiệu suất của trang.

- Trong những trường hợp như vậy, doanh nghiệp có thể thêm thẻ "không có chỉ mục" vào trang đích và thẻ sẽ không hiển thị trong kết quả của công cụ tìm kiếm. Họ cũng có thể thêm thẻ "không cho phép" trong trang hoặc trong tệp robots.txt và trình thu thập thông tin của công cụ tìm kiếm sẽ không thu thập thông tin thẻ đó.

- Chủ sở hữu trang web có thể không muốn các chương trình thu thập thông tin web thu thập thông tin một phần hoặc tất cả các trang web của họ vì nhiều lý do khác. Ví dụ: một trang web cung cấp cho người dùng khả năng tìm kiếm trong trang web có thể muốn chặn các trang kết quả tìm kiếm, vì những trang này không hữu ích cho hầu hết người dùng. Các trang được tạo tự động khác chỉ hữu ích cho một người dùng hoặc một số người dùng cụ thể cũng sẽ bị chặn.

>> Xem thêm dịch vụ seo tại đây đây: https://chuyennghiep.vn/dich-vu-seo

Sự khác biệt giữa web crawling và web scraping là gì?

.jpeg)

- Web scraping, quét dữ liệu hoặc cắt nội dung là khi một bot tải xuống nội dung trên một trang web mà không được phép, thường với mục đích sử dụng nội dung đó cho mục đích xấu.

- Web scraping thường được nhắm mục tiêu nhiều hơn thu thập dữ liệu web. Trình thu thập dữ liệu web có thể chỉ sau các trang cụ thể hoặc các trang web cụ thể, trong khi trình thu thập dữ liệu web sẽ tiếp tục theo dõi các liên kết và thu thập thông tin các trang liên tục.

- Ngoài ra, các bot quét web có thể bỏ qua sự căng thẳng mà chúng đặt trên các máy chủ web, trong khi các trình thu thập dữ liệu web, đặc biệt là từ các công cụ tìm kiếm lớn, sẽ tuân theo tệp robots.txt và giới hạn các yêu cầu của chúng để không đánh lừa máy chủ web.

>> Xem đầy đủ: Kiến thức SEO

Trình thu thập dữ liệu web ảnh hưởng đến SEO như thế nào?

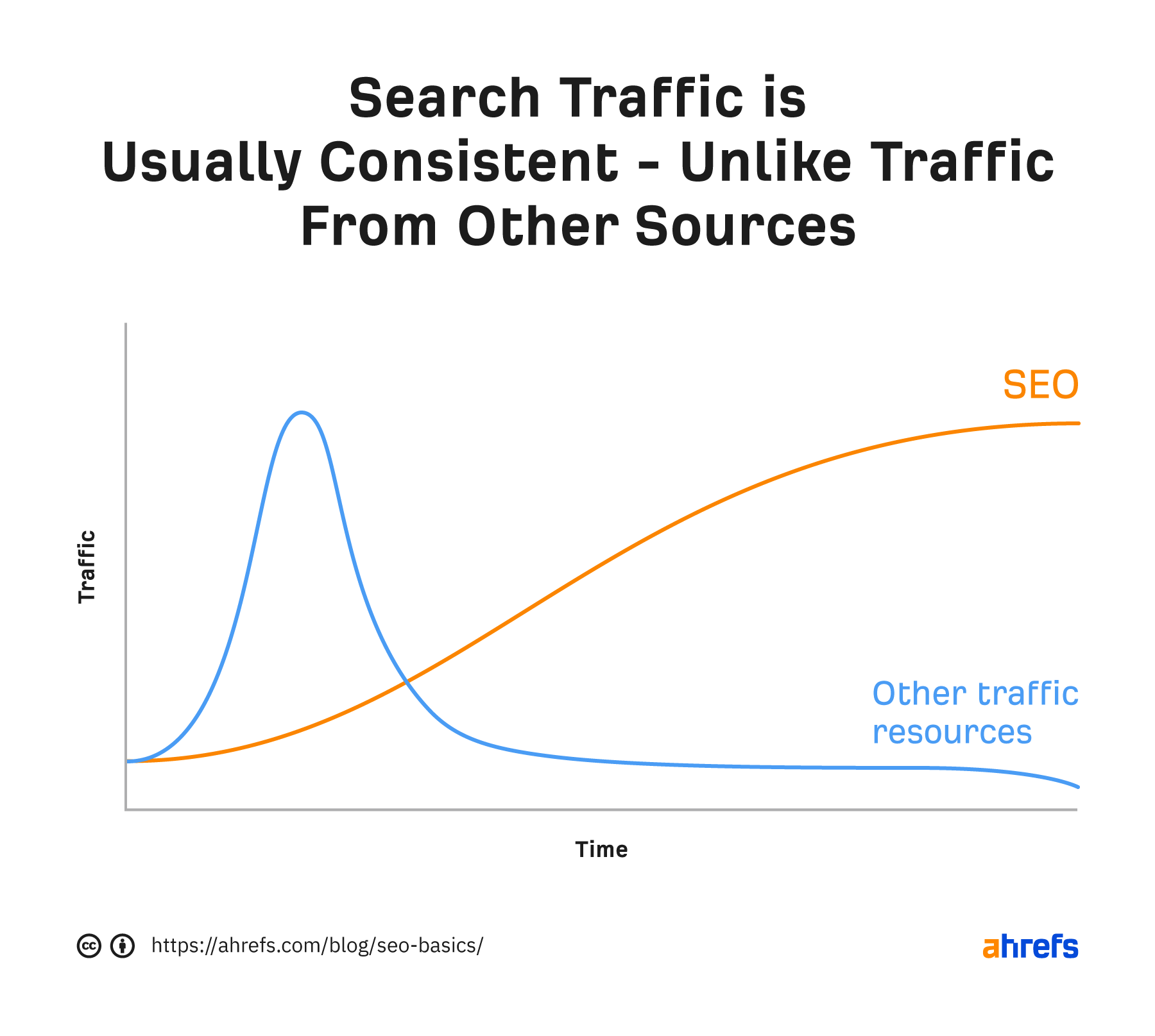

- SEO là viết tắt của tối ưu hóa công cụ tìm kiếm, và nó là kỷ luật chuẩn bị nội dung để lập chỉ mục tìm kiếm để một trang web hiển thị cao hơn trong kết quả của công cụ tìm kiếm.

- Nếu nhện bot không thu thập dữ liệu một trang web, thì nó sẽ không thể được lập chỉ mục và nó sẽ không hiển thị trong kết quả tìm kiếm. Vì lý do này, nếu chủ sở hữu trang web muốn nhận được lưu lượng truy cập không phải trả tiền từ kết quả tìm kiếm, điều rất quan trọng là họ không chặn các chương trình thu thập thông tin web.

Những chương trình thu thập thông tin web nào đang hoạt động trên Internet?

Các bot từ các công cụ tìm kiếm chính được gọi là:

- - Google: Googlebot (thực tế là hai trình thu thập thông tin, Googlebot Desktop và Googlebot Mobile, dành cho tìm kiếm trên máy tính để bàn và thiết bị di động)

- - Bing: Bingbot

- - Yandex (công cụ tìm kiếm của Nga): Yandex Bot

- - Baidu (công cụ tìm kiếm của Trung Quốc): Baidu Spider

Ngoài ra còn có nhiều bot trình thu thập thông tin web ít phổ biến hơn, một số trong số đó không được liên kết với bất kỳ công cụ tìm kiếm nào.

Tại sao việc quản lý bot lại quan trọng đến việc thu thập dữ liệu web?

- Các chương trình xấu có thể gây ra rất nhiều thiệt hại, từ trải nghiệm người dùng kém đến sự cố máy chủ đến đánh cắp dữ liệu. Tuy nhiên, trong việc chặn các bot xấu, điều quan trọng là vẫn cho phép các bot tốt, chẳng hạn như trình thu thập thông tin web, truy cập vào các thuộc tính web.

- Cloudflare Bot Management cho phép các bot tốt tiếp tục truy cập các trang web trong khi vẫn giảm thiểu lưu lượng bot độc hại . Sản phẩm duy trì một danh sách cho phép được cập nhật tự động gồm các bot tốt , như trình thu thập thông tin web, để đảm bảo chúng không bị chặn. Các tổ chức nhỏ hơn có thể đạt được mức độ hiển thị và kiểm soát tương tự đối với lưu lượng truy cập bot của họ với Chế độ chiến đấu Super Bot , có sẵn trên các gói Cloudflare Pro và Business.

>> Xem thêm dịch vụ thiết kế website tại đây: https://chuyennghiep.vn/thiet-ke-website.html